Сегодня мы рассмотрим 10 концепций прикладной статистики, которые могут быть полезны при анализе больших данных. Эти концепции затрагивают точность прогноза, интерактивный анализ и другие аспекты.

Часто аналитики забывают о прикладной статистике, хотя эта дисциплина крайне актуальна в контексте Big Data. Сегодня мы выделим основные концепции прикладной статистики, применимые в сфере больших данных.

1. Когда целью является точность прогноза, необходимо применять ансамбли моделей

Большинство алгоритмов, выигрывающих соревнование на Kaggle — это ансамбли нескольких моделей. Идея заключается в том, что усреднение (averaging) или объединение на основе принципа большинства голосов (majority voting) прогнозов нескольких хороших моделей позволяет уменьшить дисперсию (variance), не увеличивая при этом смещение (bias).

Одной из первых реализаций этой идеи был алгоритм, основанный на бутстреппинге (bootstrapping) и множестве прогнозных функций, называемый беггингом (bagging, сокращение от bootstrap aggregating – агрегирование на основе бутстреппинга).

Случайный лес (random forest) – еще один очень успешный алгоритм, применяющий похожую идею к деревьям решений.

2. При тестировании множества гипотез необходимо применять коррекцию для множественного тестирования

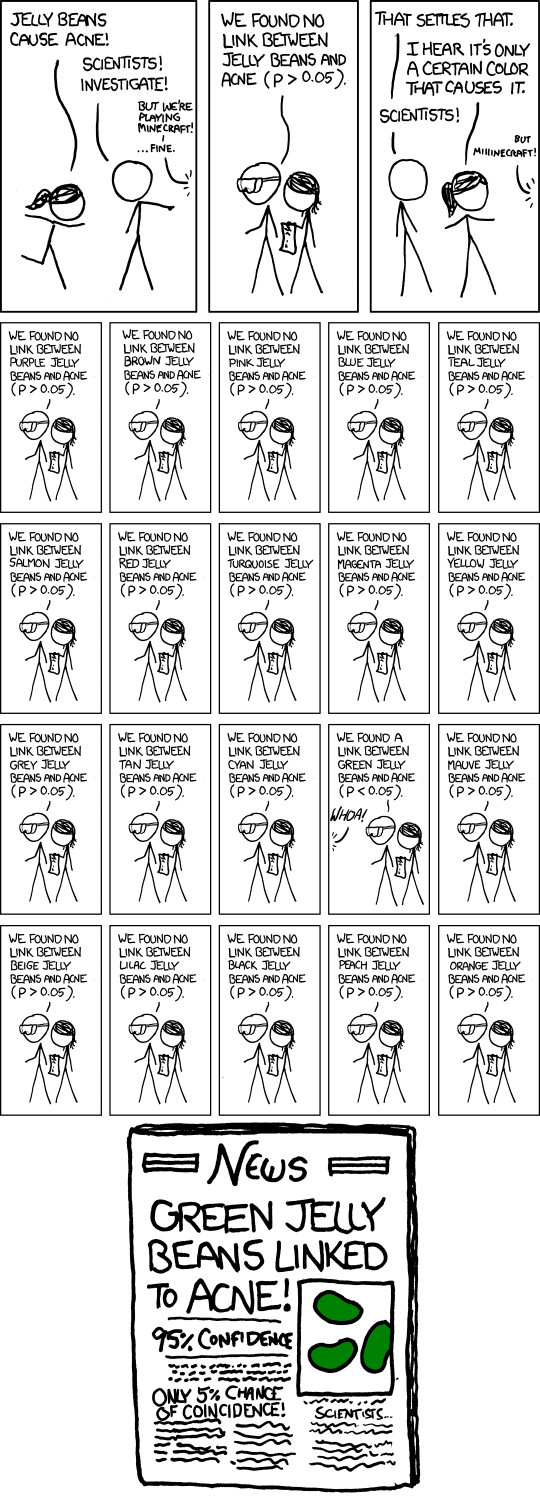

Данный комикс иллюстрирует проблему стандартного подхода к проверке гипотез, когда выполняется множество тестов:

Классические тесты разработаны таким образом, что результаты называются значимыми в 5% случаев, даже если нулевая гипотеза истинна. Распространенным способом коррекции для множественного тестирования является FDR (false discovery rate, коэффициент ложных обнаружений). Этот показатель позволяет контролировать долю результатов, названных значимыми, но являющихся на самом деле ложными обнаружениями (false discovery). Исследователи любят этот показатель, потому что его можно интерпретировать, как процент шума среди обнаруженных сигналов. Определение и процедура контроля FDR впервые были представлены в работе [Benjamini and Hochber]. Кроме того, очень хорошим введением в FDR является публикация [Storey and Tibshirani].

3. Если данные представляют собой измерения относительно пространства или времени, необходимо применять сглаживание

Эта идея – одна из старейших в статистике (в частности, регрессия, популяризованная Фрэнсисом Гальтоном (Francis Galton), является формой сглаживания). Лично я предпочитаю метод локально взвешенного сглаживания (locally weighted scatterplot smoothing, LOESS). Подробнее о данном методе можно прочитать в следующей работе. Ниже представлена демонстрации LOESS на GIF-изображении:

Существую также и другие не менее популярные методы сглаживания: сглаживание с помощью сплайнов (smoothing spline), скрытые марковские модели (hidden Markov model), скользящее среднее (moving average) и др.

4. Перед машинным анализом данные необходимо визуализировать

Распространенная ошибка начинающих аналитиков заключается в том, что они сразу же начинают обучать модели и применять различные передовые инструменты. Однако если предварительно не визуализировать данные, можно упустить из виду очевидные вещи. Хорошей иллюстрацией является квартет Энскомба (Anscombe’s quartet).

Существует целый ряд специализированных типов диаграмм, обеспечивающих эффективный визуальный анализ. Особого внимания заслуживает диаграмма Бланда-Альтмана (Bland–Altman plot или MA-plot в сфере геномики).

Данная диаграмма применяется при сравнении результатов измерений, полученных с помощью различных технологий. Язык R предоставляет множество средств визуализации, при этом следует особо отметить библиотеку ggplot2.

5. Чтобы хорошо разобраться в наборе данных, необходимо применять интерактивный анализ

Если аналитик хочет понять набор данных, он должен иметь возможность манипулировать данными и исследовать их. В частности, необходимо создавать различные таблицы и диаграммы, выявлять аномалии, находить закономерности отсутствия данных, а также определять другие особенности данных. Чтобы реализовать это, необходимо быстро взаимодействовать с данными. Одним из подходов является анализ полного набора данных целиком с помощью таких инструментов, как Hive, Hadoop или Pig. Однако часто более простым, удобным и экономичным подходом является использование случайных выборок (random sampling). Как сказал Роберт Джентльмен (Robert Gentleman): «Старайтесь сделать большие данные как можно меньшими как можно быстрее» («Make big data as small as possible as quick as possible»).

6. Важно знать реальный объем выборки (sample size)

Объем данных может легко сбить нас с толку. Представим, что у нас есть изображение черной окружности на белом фоне, сохраненное в виде пикселей. С увеличением разрешения увеличивается и объем данных, при этом количество информации может не изменяться (векторная графика). Аналогично в сфере социальных сетей: количество людей в сети может не соответствовать объему выборки. Если сеть очень плотная (dense), объем выборки может быть значительно меньше. В общем случае, чем больше объем выборки, тем лучше. При этом объем выборки (sample size) и объем данных (data size) могут не коррелировать друг с другом.

7. Аналитик всегда должен помнить о потенциальных конфаундерах

Концепция искажающих факторов или конфаундеров (confounder) является одной из фундаментальных в статистическом анализе. Конфаундеры являются причинами ложных корреляций (spurious correlation), примеры которых представлены на данном ресурсе. Как известно конфаундеры существенно затрудняют исследования в области питания. Это объясняется тем, что человеку трудно придерживаться случайной диеты, кроме того, люди, питающиеся здоровой пищей, могут отличаться от людей, не питающихся здоровой пищей, не только по диете, но и по другим важным параметрам. В сфере больших данных конфаундеры могут представлять собой технические переменные, характеризующие способ получения данных, или переменные, описывающие различия, возникающие с течением времени, в контексте поисковых систем. Когда мы обнаруживаем интересный новый результат, первая наша мысль должна быть следующей: «Какие могут быть потенциальные конфаундеры?»

8. Цель исследования должна быть определена заранее

Эта простая идея является одной из важнейших в статистике и теории принятия решений (decision theory). Например, часто нашей целью является поиск корреляций. Прикладная статистика предупреждает нас о том, что очень опасно изменять цель исследования постфактум. То есть, если мы обнаружили корреляцию, мы не должны думать, что можем предсказать новый результат, или что мы выяснили направление причинно-следственной связи.

9. Полезно отдать свой код на проверку другому специалисту

При работе с большими данными и сложными моделями существует большая вероятность появления ошибок в коде. Организация Mozilla Science реализует интересный проект по анализу кода, предназначенного для обработки научных данных. В целом, если просто попросить приятеля просмотреть код, ошибки или другие проблемы могут быть обнаружены намного быстрее.

10. На первом месте должна стоять сама задача, а не методология ее решения

В прикладной статистике существует искушение применять инструмент, которым мы хорошо владеем (например, регрессию), для решения различных задач (например, эпидемиологических), вне зависимости от их специфики.

Аналогичное искушение существует и в сфере больших данных: мы склонны концентрировать наше внимание на инструментах (таких как Hadoop, Pig, Hive, NoSQL, распределенные вычисления, вычисления на GPU и т.д.), забывая при этом о сути задачи.

По материалам KDnuggets